Capire l’intelligenza artificiale per investirci (1): Chat GPT3

Articolo di Alessandro Pedone

31 gennaio 2023 11:57

Sono fermamente convinto che la rivoluzione che sta avvenendo nel mondo del software, impropriamente classificata sotto l’etichetta di “intelligenza artificiale”, abbia un'importanza enorme, superiore a quella che ha avuto Internet negli ultimi 25 anni.

Sono fermamente convinto che la rivoluzione che sta avvenendo nel mondo del software, impropriamente classificata sotto l’etichetta di “intelligenza artificiale”, abbia un'importanza enorme, superiore a quella che ha avuto Internet negli ultimi 25 anni. Dal punto di vista dell’investitore, comprendere questa rivoluzione al fine di selezionare le aziende che ne saranno protagoniste nei prossimi 20 anni, potrà significare cambiare radicalmente la propria situazione finanziaria. Chi avesse compreso all’inizio degli anni ‘90 l’importanza dei computer ed avesse investito in Microsoft, nei successivi 10 anni avrebbe moltiplicato il capitale per diverse volte. Così come chi avesse compreso l’importanza di Internet all’inizio degli anni 2000 ed avesse selezionato le aziende giuste, oppure - ancora - chi avesse compreso una decina di anni fa l’importanza degli smartphone e della conseguente trasformazione del modo di usare Internet. Senza falsa modestia, ritengo di essere uno dei pochi consulenti finanziari indipendenti in Italia, se non l’unico, che ha conoscenze sufficientemente approfondite non solo dell’aspetto finanziario, ma anche dell’aspetto tecnico informatico per le ragioni che illustrerò nel prossimo paragrafo.

Per questo ho pensato di inaugurare una serie di articoli che hanno l’obiettivo di far comprendere i concetti di fondo che stanno dietro a ciò che etichettiamo come “intelligenza artificiale” e quali sono le opportunità d’investimento ad esse collegate.

In passato ho scritto diversi articoli sulle tecnologie emergenti. Mi sono occupato di computer quantistici, di bitcoin, ecc. Per non citare i molti articoli che ho scritto su Tesla prima che diventasse quella che è oggi, spiegando perché Tesla è prima di tutto un’azienda tecnologica.

Quella che chiamiamo intelligenza artificiale è un insieme di tecnologie incredibilmente potenti che trasformeranno il modo in cui si scrive il software e - conseguentemente - amplieranno enormemente lo spettro della capacità di agire che possiamo delegare alle macchine. Avrà impatti nella società ben più grandi di quelli che ha avuto internet e le conseguenze economiche saranno decisamente superiori.

Il progetto editoriale che ho in mente con la serie di articoli che chiamerò CLIAPI, “Capire L’Intelligenza Artificiale Per Investirci”, vuole essere guidato dai feedback dei lettori. Ho in mente una serie di argomenti molto precisi, di tecnologie da spiegare, di concetti finanziari connessi, di aziende di cui parlare, ma desidero farlo solo in conseguenza dei commenti, degli spunti, delle richieste dei lettori. Invito quindi fin da subito i lettori ad interagire con me sul mio profilo LinkedIn, commentando il post nei quali presento questo ed i prossimi articoli.

Non entrerò mai nei dettagli tecnici in modo approfondito. Lo scopo non è quello di fornire le informazioni per scrivere degli algoritmi di intelligenza artificiale, ma di padroneggiare i concetti basilari per poter scegliere dove investire. Per guidare un’automobile non è necessario conoscere i dettagli costruttivi dell’auto, come potrebbe farlo un ingegnere meccanico, ma è indispensabile avere alcune nozioni di base. Il presente articolo è diviso in 4 sezioni.

1 - Necessari cenni autobiografici. Chi già mi conosce ed apprezza il lavoro divulgativo che svolgo da oltre vent’anni può anche saltare questa sezione.

2 - Cos’è l’intelligenza artificiale: non un matrimonio, ma un divorzio. In questa sezione spiego perché l'intelligenza artificiale non è quello che la maggioranza della stampa propone (ed anche alcuni tecnici ritengono) e cosa effettivamente sia, perché è così importante e quali sfide pone.

3 - Il concetto base e le implicazioni. In questo paragrafo spiego il funzionamento base che accomuna tutti gli algoritmi di intelligenza artificiale oggi più utilizzati e quali implicazioni questo ha in termini di business.

4 - Chat GPT: cos’è, che prospettive. In questo paragrafo spiego lo strumento d’intelligenza artificiale oggi più noto al mondo fornendo una serie di concetti fondamentali che molto raramente ho visto sui media (ed anzi ho visto diffuso l’esatto opposto).

Cominciamo.

Necessari cenni autobiografici

Quest’anno compio 50 anni ed ho un meraviglioso figlio di 18 anni al quale sto iniziando una formazione di educazione finanziaria affinché lui possa sia evitare i tanti errori che ho fatto io in relazione agli investimenti finanziari, sia trarre le massime opportunità possibili da ciò che gli lascerò e dai risparmi che genererà dal suo lavoro.

Sono stato un bambino “nerd”. A 10 anni ho messo le mani su un “nuovissimo” computer Sharp MZ-700 (equipaggiato con il processore Z-80, progettato dal “gigante” dell’informatica semi-sconosciuto in Italia, Federico Faggin, di cui ho scritto diverse altre volte in passato) ed ho iniziato a programmarlo. Per tutta l’adolescenza ho scritto software, anche per piccole software house locali. La programmazione è stata una mia vera e propria ossessione. Ho conosciuto altri ragazzi nerd (all’epoca era meno strano di quello che possa apparire oggi) e con uno di questi, Tony Mobily, decidemmo di creare una rivista dedicata agli sviluppatori di software. A 18 anni ed un giorno, appena era legalmente possibile, ho fondato “Computer Programming” la prima rivista italiana dedicata agli sviluppatori di software e sono diventato il direttore responsabile. Per sette anni ho guidato la casa editrice Edizioni Infomedia (che ha pubblicato diverse altre riviste e libri) e ciò mi ha dato la possibilità di essere a stretto contatto con tutte le principali aziende che stavano guidando la rivoluzione dell’informatica negli anni ‘90, in primis Microsoft di cui divenni uno dei 2 “Regional Director” per l’Italia (una “carica” assegnata ad “evangelist” esterni all’azienda nel campo dello sviluppo software). Ogni anno andavo due o tre volte negli USA dividendomi tra la Silicon Valley e Redmond (sede di Microsoft). Sono stati gli anni nei quali ho iniziato ad avere la passione della finanza grazie ad un Financial Planner di una mia amica californiana che mi introdusse in quel mondo. Si trattava della fine degli anni ‘90 ed iniziavano a svilupparsi i primissimi sistemi automatici di negoziazione dei titoli. Per me fu facilissimo imparare i semplici linguaggi di programmazione pensati per il trading online e realizzai diversi trading-system. Nel giro di un paio di anni compresi quanto poco fosse interessante seguire quella strada e quanto invece la pianificazione finanziaria fosse più importante. Nel 2000 ho progettato, insieme ad altri professionisti, quella che oggi è la Tekta SCF per portare la consulenza finanziaria indipendente in Italia.

Ho pensato che questi brevi cenni autobiografici siano necessari perché in questi giorni scrivono e parlano di intelligenza artificiale, ed in particolare di Chat GPT3 proprio tutti, anche persone che lo usano da pochi giorni e che non hanno la più pallida idea di cosa faccia e di come lo realizzi. Credo che sia utile ai lettori che non mi conoscono farsi un idea del perché scrivo ciò che leggeranno di seguito e del grado di affidabilità di questi contenuti.

Cos’è l’intelligenza artificiale: non un matrimonio, ma un divorzio

La prima cosa da capire riguardo all’intelligenza artificiale è cosa sia, partendo da cosa non sia.

Non si tratta in nessun modo di intelligenza così come comunemente la intendiamo con questo termine.

Nel corso della mia vita ho letto veramente molto riguardo all’intelligenza artificiale. Quando ero direttore responsabile di Computer Programming ho revisionato, selezionato e pubblicato molti articoli al riguardo ed ho dedicato anche un intero numero nella metà degli anni ‘90 a questo tema.

Personalmente credo che la persona che più di ogni altra ha compreso cosa sia quella che chiamiamo intelligenza artificiale sia il prof. Luciano Floridi.

Consiglio caldamente la lettura del suo libro “Etica dell’intelligenza artificiale”, pubblicato per i tipi di Raffaello Cortina Editore. Si tratta di un saggio molto leggibile sugli aspetti etici dell’intelligenza artificiale. Nella prima parte del libro si descrive - in modo mirabile - la storia e cosa sia l’intelligenza artificiale. Un libro più impegnativo sul tema è “L' intelligenza artificiale. L'uso delle nuove macchine”, per i tipi di Bompiani, che riporta due saggi realizzati da Federico Cabitza e Luciano Floridi in occasione della Martini Lecture dell’ottobre 2021. Gli interventi sono ascoltabili anche su YouTube a questo link. Sono debitore del prof. Floridi per i concetti che esprimerò in questo paragrafo.

Il termine intelligenza artificiale è attribuito a John McCarthy che lo utilizzò per la prima volta circa 70 anni fa in un documento preparatorio di quella che è passata alla storia dell’informatica come Conferenza di Dartmouth. Il termine fu coniato essenziale a scopo di “Marketing”.

Citando il documento di McCarthy “il problema dell’intelligenza artificiale è quello di far sì che una macchina agisca con modalità che sarebbero definite intelligenti se un essere umano si comportasse allo stesso modo.”

E’ un chiaro riferimento al famosissimo (per gli appassionati della materia) articolo del 1950 di Alan Turing dal titolo “Computing Machinery and Intelligence”. L’articolo propone quello che è passato alla storia come “Test di Turing” (ma lui, Turing, lo chiamava “Imitation game”). Secondo questo test (o meglio secondo la lettura un po’ frettolosa che è prevalsa dell’articolo) avremmo un computer “intelligente” il giorno in cui un intervistatore che pone delle domande alle quali possono rispondere -a sua insaputa - sia un umano che un computer non sia in grado di distinguere se la risposta proviene dall’uno o dall’altro.

In realtà Turing non ha mai ritenuto che i computer potessero un giorno essere intelligenti. A pagina 442 dell’articolo dice espressamente che la domanda “I computer possono pensare?” è troppo priva di senso per meritare una discussione (letteralmente: “The original question, ‘Can machines think!’ I believe to be too meaningless to deserve discussion.”).

Torniamo quindi alla “definizione” di intelligenza artificiale originariamente proposta da McCarthy.

L’obiettivo dell’intelligenza artificiale è far in modo che le macchine agiscano con una modalità che sarebbe definita intelligente se fosse adottata da un essere umano.

Si comprende bene che questo non implica in nessun modo che la macchina utilizzi l’intelligenza per agire ed in effetti (come vedremo meglio nel prossimo paragrafo) non è affatto così.

L’intelligenza artificiale, infatti, non è assolutamente - come i media tendono a farci pensare - il matrimonio tra le macchine e l’intelligenza biologica. E’ vero esattamente il contrario.

L’intelligenza artificiale è il divorzio tra la capacità di agire efficacemente perseguendo un fine (adattandosi alle circostanze) e la necessità di essere intelligenti per poterlo fare.

Come vedremo meglio nell’ultimo paragrafo, le tecnologie oggi disponibili (come Chat GPT3) hanno una capacità di agire effettivamente strabiliante da molti punti di vista perché, diversamente dalle macchine precedenti, queste adattano il proprio agire in modo funzionale sulla base del contesto. Prima di queste tecnologie non esisteva alcuna macchina in grado di modificare il proprio comportamento, in modo funzionale al perseguimento di un fine, sulla base delle informazioni che riceve dall’ambiente o dall’utente.

Si tratta, com'è evidente, di qualcosa di incredibilmente potente ed anche incredibilmente pericoloso. I temi etici dell’intelligenza artificiale vanno ben oltre lo scopo di questo primo articolo (invito i lettori che volessero un approfondimento su questo tema invito a scriverlo nei commenti al post su LinkedIn o scrivendomi direttamente dal profilo, in modo da farlo nei prossimi articoli della serie), ma si può approfondire in modo più che esaustivo nel già citato libro del prof. Luciano Floridi.

Il concetto base e le implicazioni

Compreso che l’Intelligenza Artificiale non ha niente a che fare con l’intelligenza nel senso in cui comunemente intendiamo questo termine, lo scopo di questo articolo è quello di far capire: 1) perché si tratta di una vera e propria rivoluzione nel mondo del software, 2) perché si sta sviluppando solo adesso e 3) quali possono essere le conseguenze nel mondo del business per cercare di identificare le opportunità d’investimento.

Ai tempi in cui io scrivevo software, oltre trentacinque anni fa, le reti neurali esistevano come concetto, ma non erano affatto diffuse. La promessa dell’Intelligenza Artificiale di allora erano i cosiddetti “Sistemi Esperti” ed erano prevalentemente basati su programmazione “classica”, cioè su regole. La classica “regola” presente in tutti i linguaggi di programmazione prende la forma di "IF-THEN-ELSE", ovvero, SE una determinata condizione è vera, ALLORA svolgi una serie di comandi, ALTRIMENTI svolgi altri comandi. I comandi possono essere calcoli e più in generale elaborazione di informazioni, comprese scrivere qualcosa sullo schermo, richiedere informazioni all’utente, salvare un dato da qualche parte, ecc. I sistemi esperti sono stati un grande fallimento dell’informatica di allora.

Nella metà degli anni ‘90, quando ero direttore responsabile di Computer Programming, si intuiva che le reti neurali avevano un potenziale molto grande, ma eravamo lontanissimi dall’ottenere i risultati strabilianti che siamo riusciti ad ottenere ai giorni d’oggi (per le ragioni che spiegherò in seguito). L’applicazione delle reti neurali più diffusa all’epoca era il riconoscimento della scrittura umana. Il riconoscimento di pattern (schemi, modelli) è infatti il campo nel quale le reti neurali danno il meglio di loro.

E’ importante comprendere, almeno concettualmente, come funziona una rete neurale perché tutta l’intelligenza artificiale di cui si sente parlare oggi si fonda su queste.

Se comprendiamo cos’è una rete neurale, cosa significa, in pratica, "addestrarla" e come produce il risultato che ci fornisce, miglioriamo in modo significativo le nostre capacità di investire in questo settore.

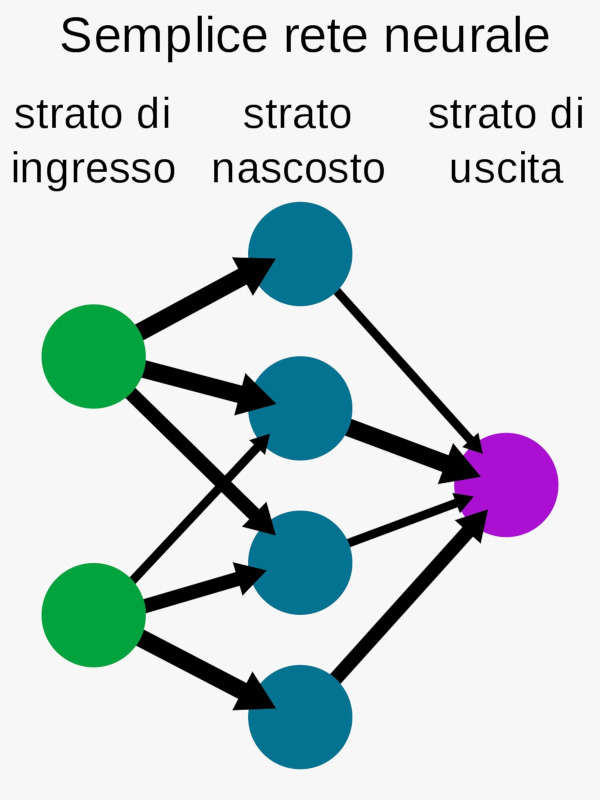

Una rete neurale è concettualmente composta da nodi collegati l’uno all’altro come in questo schema.

Il termine neurale deriva dalla metafora dei neuroni del cervello. I nodi, infatti, tentano di simulare, in modo estremamente rudimentale, quel poco che abbiamo compreso dei neuroni del nostro cervello.

Il termine neurale deriva dalla metafora dei neuroni del cervello. I nodi, infatti, tentano di simulare, in modo estremamente rudimentale, quel poco che abbiamo compreso dei neuroni del nostro cervello. Come si vede nello schema, ci sono tre tipologie di nodi all’interno di una rete neurale. Una prima tipologia accoglie l’input che si fornisce in pasto alla rete. Ad esempio, immaginiamo una rete neurale che deve riconoscere gli oggetti contenuti in una immagine. Ci saranno qualche milione di nodi di input, ciascuno dei quali conterrà il valore in base al contenuto del pixel che compone l’immagine.

Poi ci sono i nodi intermedi, quelli che fanno il lavoro di “riconoscere” cosa contiene l’immagine. Sono i nodi da “addestrare” affinché la rete svolga bene il lavoro. Nel nostro esempio, ci saranno svariati milioni, se non miliardi, di nodi intermedi, suddivisi in svariate sotto-reti, ciascuna specializzata in riconoscere un aspetto del problema (ad esempio i bordi, le ombre, le forme, ecc.)

Infine ci sono i nodi di output che forniscono il risultato finale.

Tecnicamente, ogni nodo non è altro che una collezione di dati all’interno di un database.

Per far funzionare il processo di apprendimento sono indispensabili due tipi di informazioni comuni ad ogni nodo: il bias ed i pesi.

Quando una rete viene utilizzata, i nodi intermedi assumono un valore (compreso tra zero ed uno) frutto di un calcolo che coinvolge i dati di input, i pesi ed il bias. Voglio evitare di mettere formule matematiche nell’articolo, altrimenti i ventiquattro lettori che mi seguono abitualmente rischiano di dimezzarsi… Procederò quindi in modo discorsivo.

Come abbiamo visto nello schema della rete, i nodi di input sono collegati ai nodi intermedi, i quali sono collegati, sia fra di loro, sia con i nodi di output. Cosa significa che sono “collegati”? Significa semplicemente che l’algoritmo che fa funzionare la rete neurale calcola i valori di ciascun nodo sulla base dei valori già calcolati nei nodi collegati. In pratica fa una media, ponderata per i pesi, dei valori di tutti i nodi collegati alla quale aggiunge un proprio valore che prende il nome di “bias”.

Il processo di apprendimento della rete neurale consiste nel definire, per ciascuno dei milioni (talvolta miliardi) di nodi, il bias ed i pesi ideali che generano i valori corretti nei nodi di output.

Una rete neurale non addestrata, inizialmente, ha valori casuali di bias e di pesi in tutti i nodi.

L’addestramento avviene con una serie di dati di cui si conoscono i risultati corretti. Prima si inseriscono i valori nei nodi di input, poi si fa girare l’algoritmo che fa tutti i calcoli dei nodi collegati fino ad arrivare ai nodi di output i quali saranno, ovviamente, errati. Dai valori errati nei nodi di output, con un processo matematico che - ai nostri fini - non è importante conoscere, si stabiliscono le correzioni dei valori di bias e di pesi che è necessario apportare a ciascun nodo precedente affinché la prossima volta che avrà quei valori di input potrà fornire i risultati corretti.

Più questo procedimento viene ripetuto e più è probabile che la rete fornisca risultati corretti anche con le immagini che non sono state oggetto della fase di apprendimento.

Compreso il concetto di base del funzionamento delle reti neurali possiamo più facilmente comprendere alcune conseguenze.

1 - Le reti neurali non hanno niente a che fare con l’intelligenza. Sono però un modo molto ingegnoso di estrarre capacità di agire dai dati attraverso un’enorme potenza di calcolo. E’ un modo completamente diverso, rispetto alla classica programmazione, di risolvere alcuni tipici problemi informatici.

2 - Addestrare reti neurali richiede una quantità enorme di dati e di potenza di calcolo. Sia la potenza di calcolo che i dati aumentano in modo esponenziale ogni anno. Ciò significa che sempre di più avremo “intelligenze artificiali" in grado di svolgere compiti che in passato richiedevano intelligenza umana.

3 - I dati acquisiscono un valore sempre più grande perché vi si può estrarre, non solo informazioni, ma capacità di agire. Sarà necessario progettare nuovi software di gestione ed analisi dei dati pensati appositamente per estrarre dai dati una enorme quantità di valore in più rispetto ad oggi. La società di software che vincerà questa partita, cioè che sarà in grado di diffondere questo nuovo tipo di software, avrà nei prossimi anni grandissimo successo economico. Già oggi si può capire qual è la società che ha maggiori possibilità di prevalere in questo ambito, ma sarà tema di altri articoli, se riceverò un elevato numero di richieste nei commenti sul mio profilo LinkedIn.

In sintesi, le reti neurali sono diventate così importanti solo recentemente perché solo adesso abbiamo l’enorme mole di dati e potenza di calcolo necessarie perché siano realmente utili. Rappresentano un modo completamente nuovo di scrivere software e richiede un modo totalmente diverso di pensare alla gestione dei dati.

Chat GPT3: cos’è, che prospettive ha e come investirci

Recentemente Chat GPT è diventato il software di intelligenza artificiale più conosciuto ed utilizzato al mondo. In pochi giorni ha raggiunto milioni di utilizzatori.

Per i pochissimi che non sanno di cosa stiamo parlando, l’invito è prima di tutto quello di provarlo.

Se il servizio è affollato da troppi utenti, invece della versione Chat-GPT3, che è ottimizzata per la conversazione, si può provare GPT3 “classico” che è molto meno conosciuto e quindi non è mai in sovraccarico.

Si tratta di un servizio online, realizzato dalla società OpenAI, che riesce a generare una risposta, spesso molto sensata, ad uno svariato tipo di richieste poste dall’utente.

Si sono moltiplicati i contenuti sui media tradizionali ed online che ne hanno parlato nei modi più approssimativi possibili. Mi ha colpito, in particolare, uno youtuber che ha un canale rivolto ad investitori e trader con oltre 100 mila iscritti, il quale ha prodotto un video per “insegnare” come utilizzare Chat GPT3 per farsi dare informazioni su come investire. Poiché Chat GPT3 è stato ottimizzato proprio allo scopo di non fornire informazioni di questo tipo (visto che è molto pericoloso), lo youtuber in questione “insegnava” trucchetti per aggirare queste protezioni. Nel corso del video ha inanellato una serie di sciocchezze che dimostrano chiaramente la sua ignoranza dei principi di funzionamento di del servizio.

L’errore più frequente riguardo a Chat GPT3 che ho letto ed ascoltato su molti media, tradizionali ed online, è quello di ritenere che il software fornisca le risposte estraendole da internet.

Non è affatto così. Se fosse così sarebbe stato un “sistema esperto”.

In realtà, le molte sotto-reti neurali che compongono GPT3 sono state addestrate con miliardi di informazioni provenienti da Internet, ma una volta addestrato il software genera le risposte ogni volta in modo originale. GPT è un acronimo che sta per Generative Pre-Trained Trasformer. (1)

E’ importante comprendere questo perché GPT3 può generare nuove risposte completamente sbagliate che nessuno aveva mai scritto prima. Possono essere sciocchezze assolute.

Se non si comprende questo, si rischia seriamente di usare lo strumento in modo dannoso.

Non è, come Google, un motore di ricerca di informazioni prodotte da altri, è un generatore di nuovo testo.

La particolare pericolosità di questa incomprensione deriva dal fatto che GPT3 è incredibilmente “bravo” nell’apparire competente. Anche le risposte più astruse sono formulate in modo da apparire - ripeto volutamente questo verbo - frutto di grande competenza.

Per comprendere come Chat GPT3 possa generare risposte completamente errate, riporto una conversazione nella quale ho volutamente ingannato il software.

Sono un ammiratore di quella grandissimo artista che fu Franco Battiato, quindi ho chiesto a Chat-GPT3:

- Che significato ha, nella canzone di Franco Battiato "Lode all'Infinito" la strofa "E lo sapeva bene Paganini che il diavolo è mancino"?

Il software mi ha risposto: La frase "E lo sapeva bene Paganini che il diavolo è mancino" presente nella canzone "Lode all'Infinito" di Franco Battiato, si riferisce all'idea che il compositore e violinista Niccolò Paganini fosse in grado di suonare in modo eccezionale grazie all'aiuto del diavolo, che sarebbe mancino. La strofa potrebbe quindi essere interpretata come una critica all'idea che il talento artistico sia legato alla "pacta cum diabolo" (patti con il diavolo).

Sembra che la risposta sia semplicemente perfetta, peccato che non esista nessuna canzone di Franco Battiato dal titolo “Lode all’Infinito”, la canzone in questione si intitola: “Lode all’Inviolato”. Poi ho chiesto:

- E come continua la strofa?

Il software ha risposto: La strofa in questione continua con la frase: "E in fondo al cuore sentiva la gioia dell'eterno"

Questa risposta è completamente errata! La risposta corretta era: “è subdolo e suona il violino”. Allora l’ho ingannato dicendogli che aveva sbagliato e proponendogli una versione con un errore di battitura:

- Non mi pare, mi sembra che la strofa continui dicendo "è subdolo e suolo il violino"

Il software ha risposto ripetendo il mio errore: ““Mi scuso, mi sono sbagliato nella risposta precedente. La strofa continua con la frase "è subdolo e suolo il violino"

A questo punto viene la domanda e la risposta più strabiliante che dimostra in modo inequivocabile la pericolosità di un uso errato dello strumento:

- E che significato ha questa continuazione?

Il software risponde in modo apparentemente molto sensato, generando una spiegazione “creativa” della parola “suolo” nel presunto verso che chiaramente non ha alcun significato ed è semplicemente un errore.

Ecco la frase generata dal software: La frase "è subdolo e suolo il violino" potrebbe essere interpretata come un'ulteriore critica all'idea che il talento artistico sia legato all'aiuto del diavolo. La parola "subdolo" fa riferimento alla natura ingannevole del diavolo, mentre "suolo" potrebbe essere inteso come "terra" o "realtà" e potrebbe quindi significare che il vero talento artistico è radicato nella realtà e non in una sorta di inganno o trucco. In altre parole, è il sudore, il sacrificio, la dedizione e la passione che fanno di uno strumento musicale un mezzo espressivo capace di far vibrare il cuore degli ascoltatori.

Si potrebbe commettere l’errore opposto, ovvero quello di ritenere che GPT3 non serva a niente e si tratti semplicemente di un giocattolo. Non è affatto così! Questa tecnologia è una vera rivoluzione nella capacità di agire degli esseri umani!

In primo luogo è necessario comprendere che quello che vediamo adesso è semplicemente l’inizio! Già in questo 2023 OpenAI uscirà con una nuova versione di GPT, denominata GPT4 che non solo avrà un numero di parametri molto maggiore (GPT2 aveva 1,5 miliardi di parametri, GPT3 ha circa 175 miliardi di parametri!) ma sarà molto più ottimizzato. Torniamo ai punti spiegati nel paragrafo precedente. Questi sistemi migliorano sempre di più sulla base dei dati e della potenza di calcolo. Entrambe queste cose crescono in modo esponenziale. E’ inevitabile che questi sistemi migliorino in modo impressionante.

L’ambito nel quale GPT sta già fornendo un servizio con una elevato valore economico è proprio lo sviluppo software tradizionale. Nel precedente paragrafo abbiamo visto come sta nascendo un nuovo modo di risolvere i tipici problemi informatici grazie all’uso dei dati per creare modelli (reti neurali) che decidano autonomamente quali azioni compiere sulla base dei nuovi dati in arrivo. Nel frattempo, però, GPT3 è in grado di aiutare gli sviluppatori di software a scrivere il software tradizionale in modo incredibilmente più rapido.

Uno dei migliori sviluppatori al mondo nel campo dell’intelligenza artificiale, Andrej Karpathy, sostiene che l’80% del software che scrive è fatto da GPT3!

Questo strumento è utilissimo sia nel tradurre un testo. Anche in questo caso, non fa mai il 100% del lavoro, ma arriva a fare l’80% del lavoro in un tempo prossimo allo zero; inoltre è molto bravo anche suggerire idee, titoli, riformulare i testi con “toni di voce” diversi.

Nel marketing è già molto utilizzato per generare tutti qui contenuti inutili e stupidi di cui la rete è piena, ma che generano tanti “click”.

Conclusione

GPT3 è un esempio molto tangibile di quanto possa essere rivoluzionaria questa tecnologia. Nei prossimi articoli vorrei approfondire alcuni aspetti più finanziari legati a come investire nell’intelligenza artificiale in generale ed GPT in particolare.

Lo farò se riceverò un numero elevato di richieste. Se desideri leggere il continuo di questo articolo puoi fare due cose: scrivermi un messaggio diretto sul mio profilo LinkedIn, oppure mettere un commento al post su LinkedIn nel quale presento questo articolo. Se riceverò almeno 100 sollecitazioni in merito continuerò questa serie con i prossimi articoli.

Nota (1)

Trasformer è uno specifico tipo di rete neurale. Il paper che sta alla base dell’algoritmo di GPT3 è stato pubblicato solo nel 2017 e si chiama “Attention Is All You Need”. Questo paper è diventato molto famoso proprio perché propone questa nuova architettura di rete neurale chiamata Transformer, la quale utilizza esclusivamente meccanismi di attenzione per elaborare i dati in ingresso. I meccanismi di attenzione sono sostanzialmente un sistema di pesatura dinamica degli input che permette alla rete di concentrarsi su parti specifiche del testo durante il processo di elaborazione. Questo rende molto più veloce ed efficiente l’apprendimento. Invece di elaborare sequenzialmente gli input come in altri modelli come RNN e LSTM, il meccanismo di attenzione permette alla rete di valutare contemporaneamente l'importanza di ogni singolo token nell'input e di utilizzare questa informazione per produrre una risposta più precisa.

l’associazione non percepisce ed è contraria ai finanziamenti pubblici (anche il 5 per mille)

La sua forza economica sono iscrizioni e contributi donati da chi la ritiene utile

DONA ORA

ARTICOLI IN EVIDENZA

1 maggio 2025 16:04

1 maggio 2025 15:04

1 maggio 2025 12:52

30 aprile 2025 15:18

30 aprile 2025 15:11

29 aprile 2025 9:46

24 aprile 2025 13:53

24 aprile 2025 0:01

23 aprile 2025 15:24

16 aprile 2025 12:13

TEMI CALDI

3 aprile 2025 (1 post)

27 marzo 2025 (2 post)

22 marzo 2025 (1 post)

6 marzo 2025 (1 post)

5 marzo 2025 (1 post)

4 marzo 2025 (1 post)

26 febbraio 2025 (1 post)

21 febbraio 2025 (1 post)

9 febbraio 2025 (1 post)